Nelze věřit vlastním očím. Technologie deepfake změní svět, Češi nejsou připraveni

Projekt vznikl za podpory firmy Gen Digital.

Video: Aktuálně.cz, Foto: Shutterstock

Fenomén deepfake

Člověk minimálně čtyři pětiny informací z okolního světa přijímá prostřednictvím zraku. Právě zrak nám umožňuje rychle a efektivně zpracovávat velké množství informací, což je klíčové pro naši orientaci a přežití. Co vidíme na vlastní oči, tomu zpravidla i věříme. Respektive nemáme důvod nevěřit. I proto je například videoobsah vůbec nejdůvěryhodnějším mediálním a komunikačním formátem.

Co je to deepfake?

Video: Tomáš Klézl, Blahoslav Baťa

Jenže, co když je video falešné a osobnost v něm dělá nebo sděluje něco, co ve skutečnosti nikdy neudělala a neřekla? Co když jde o takřka dokonalou digitální kopii člověka, která s vámi dokáže v reálném čase i komunikovat, dokonce svým hlasem, a vy nic nepoznáte?

Technologie deepfake videí je fascinující, ale zároveň nejspíš největší internetovou výzvou, před kterou dosud lidstvo stálo. Podle odborníků nastupuje fenomén, který bude pro velkou většinu lidí zcela nepochopitelný, uvrhne je do zmatku, rozklíží jejich důvěru v cokoliv. A také je učiní zranitelnými vůči různým podvodníkům a šmejdům.

Deepfake využívá pokročilé algoritmy umělé inteligence a strojového učení k vytváření neuvěřitelně realistických, ale falešných videí a audionahrávek. Umí manipulovat s obličeji, gesty a hlasy. Deepfaky se obvykle vytvářejí pomocí techniky zvané „generativní adversariální sítě“, která umožňuje trénování modelů na základě obrovského množství audiovizuálních dat.

Jak se deepfake šíří

Deepfaky se šíří především prostřednictvím online platforem, jako jsou sociální sítě, webové stránky a videoplatformy, například YouTube. Tyto platformy usnadňují rychlé sdílení obsahu, což v některých případech umožňuje, aby se deepfake videa stala virálními a rychle se šířila online prostorem. Pro uživatele je obtížné rozpoznat, zda je obsah pravdivý nebo zmanipulovaný, což zvyšuje riziko šíření dezinformací a falešných zpráv.

Tato technologie, která dokáže zcela falešná prohlášení politiků předkládat tak věrohodně, že nejsou de facto rozeznatelná od reality, dokáže snadno měnit veřejné mínění, způsobovat politické krize, šířit nenávist a v důsledku i ovlivňovat demokratické volby. Deepfake dokáže vytvářet pornografický materiál s aktéry, kteří o tom ani nevědí, což může mít devastující dopad na pověst a osobní život obětí. Zároveň je to mimořádná příležitost ke kyberšikaně a vydírání.

Jsme teprve na začátku, ale co se týče podvodů, už dnes se ve světě dějí věci naprosto nepředstavitelné.

Například CNN v únoru 2024 popsala případ zaměstnance nadnárodní firmy z Hongkongu, který převedl 25 milionů dolarů podvodníkům, protože mu k tomu při videomeetingu dal pokyn finanční ředitel společnosti. Propracovaný podvod spočíval v tom, že muž se na základě falešné výzvy připojil na briefing se svým nadřízeným a kolegy, ale všechny, které na monitoru viděl, a s nimiž komunikoval, vytvořila umělá inteligence.

Muž měl sice určité pochybnosti o neobvyklém požadavku ředitele, kterého neznal a který byl z londýnské centrály společnosti, ale vždyť přece ostatní účastníci videokonference vypadali a zněli jako jeho kolegové, které poznával.

O rafinovanosti podvodů pomocí deepfake videí hovoří i případ společnosti GymBeam, kdy po svém kolegovi při videohovoru požadoval bankovní údaje výkonný ředitel firmy. Právě jeho podobu včetně hlasu vytvořila umělá inteligence. Většinu hovoru moderoval externí právník, rozumějme podvodník, kterého ředitel v úvodu schůzky představil.

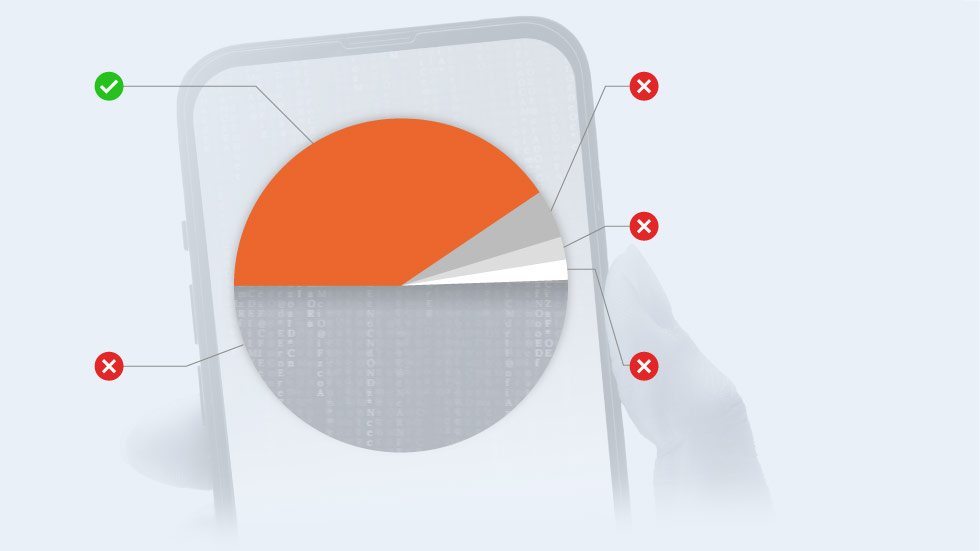

Většina Čechů neví, co to je deepfake

S tímto zjištěním přišli výzkumníci z projektu CEDMO v březnu 2024. Z tří tisíc lidí, kterých se zeptali, co to deepfake je, jich správně odpovědělo jen 41 procent.

41 %

5 %

Zdánlivě reálný, umělou

inteligencí vytvořený obraz,

video nebo zvuk něčeho,

co se nezakládá na pravdě

Chatbot (tzv. komunikující robot),

který vytváří u lidí falešnou

představu, že mluví s někým jiným

2 %

Systém postavený na umělé

inteligenci, který zaznamenává

a chrání informace v online prostředí

51 %

2 %

Nevím

Počítačový program, který se

tváří, jako by lidé používali

internet z jiného místa

41 %

51 %

Zdánlivě reálný, umělou inteligencí vytvořený obraz, video nebo zvuk něčeho, co se nezakládá na pravdě

Nevím

2 %

Systém postavený na umělé inteligenci, který zaznamenává a chrání informace v online prostředí

2 %

Počítačový program, který se tváří, jako by lidé používali internet z jiného místa

5 %

Chatbot (tzv. komunikující robot), který vytváří u lidí falešnou představu, že mluví s někým jiným

Zdroj: CEDMO Trends

Vše prasklo ve chvíli, kdy falešný ředitel uvedl, že bude mít dva týdny dovolenou. A to se jeho podřízenému zdálo podezřelé, protože se ten den oba potkali v práci. Šéfovi tedy okamžitě napsal zprávu. „Ten den jsem ho potkal v kanceláři, a proto mi v průběhu hovoru napsal na firemním Slacku. Okamžitě jsem mu řekl, že na žádném videohovoru nejsem,“ popisoval výkonný ředitel na síti LinkedIn.

S důvěřivostí lidí však pracují i mnohem méně propracované podvody. Zpravidla se snaží nalákat oběti na investování peněz do falešných investičních portálů či kryptoměn. A známe je i z Česka.

Jak proti deepfake bojovat

Čelit výzvám, které deepfaky představují pro společnost, jednotlivce a instituce, je velmi důležité. Jak se technologie vyvíjí, je nezbytné investovat do vzdělávání uživatelů a do technologií detekce. Zároveň je důležité zavést právní meze, zákony a etická pravidla používání těchto technologií, které by pomohly chránit lidi před negativními dopady deepfaků. Pouze tak lze zajistit, aby tato inovativní technologie byla využívána zodpovědně a eticky.

V dubnu 2023 médii proběhla zpráva o podvodnících, kteří na portálu YouTube lákali lidi pomocí deepfake videí s prezidentem Petrem Pavlem či premiérem Petrem Fialou k výhodnému investování. Pro větší důvěryhodnost pak známá jména politiků šejdíři zkombinovali s firmou ČEZ.

„Naletěli jsme, byli jsme důvěřiví. Ale ty metody… Oni se umí vloudit, zmanipulovat, dá se říct i zhypnotizovat, že uděláte úplné hlouposti a dojdete až k úplnému finančnímu vyčerpání. Nejsme hloupí, ale řeknu upřímně: Stydíme se,“ svěřil se muž redakci Seznam Zprávy, který s manželkou na falešnou reklamu naletěl. Pár do podvodného investování vložil přes milion korun výměnou za bezcennou fiktivní kryptoměnu. Podle policie nebyli jediní, kteří těmto konkrétním podvodníkům naletěli.

Že podobných podvodů a počet okradených bude se zdokonalováním a stále větší kvalitou a dostupností technologie deepfake přibývat, není pochyb.

Deepfake videa zkrátka představují vážnou hrozbu pro důvěryhodnost informací a soukromí jednotlivců. Je potřeba, aby technologické firmy vyvinuly co možná nejúčinnější nástroje pro jejich detekci a prevenci. A zároveň je nezbytné, aby co nejvíce lidí vědělo o jejich existenci a nebezpečích, která s sebou přinášejí. I proto redakce Aktuálně.cz spolu se společností Gen připravila tento materiál.

Nebezpečí deepfake videí v bodech

Dezinformace a manipulace: Deepfake videa mohou být použita k šíření falešných informací a manipulaci veřejného mínění. Například mohou být vytvořena videa, kde politici nebo veřejně známé osobnosti říkají nebo dělají věci, které ve skutečnosti nikdy neřekli ani neudělali. To může vést k politickým krizím, ovlivňování voleb a šíření nenávisti.

Kyberšikana a vydírání: Deepfake technologie může být zneužita k vytváření kompromitujících videí, která mohou být použita k vydírání nebo kyberšikaně. Například mohou být vytvořena falešná pornografická videa, což může mít devastující dopad na osobní a profesionální život obětí.

Porušení soukromí: Deepfake videa mohou narušovat soukromí jednotlivců tím, že je zobrazují v situacích, které nikdy nenastaly. To může vést k poškození jejich pověsti a důvěryhodnosti.

Ekonomické dopady: Deepfake technologie může být použita k podvodům a finančním ztrátám. Například mohou být vytvořena falešná videa s firemními představiteli, která mohou ovlivnit ceny akcií nebo způsobit finanční ztráty.

Detekce a prevence: Vzhledem k těmto rizikům je důležité vyvíjet technologie a postupy pro detekci a prevenci deepfake videí. Společnosti jako Microsoft a Google již pracují na nástrojích, které pomáhají identifikovat deepfake obsah a chránit veřejnost před jeho negativními dopady.

Politici budou pomocí deepfake očerňovat své konkurenty, bojí se tři čtvrtiny Čechů

Skoro tři čtvrtiny Čechů si myslí, že politici a politické strany začnou využívat deepfake k očernění svých politických konkurentů. Dvě třetiny lidí se dále domnívají, že deepfake budou používat také majitelé médií, a to k tendenčnímu prezentování informací. Vyplývá to z průzkumu agentury Median pro institut CEDMO z května 2024.

Lidé u médií případné využívání deepfake očekávají o trochu méně než u politiků. I tak se ale dvě třetiny lidí domnívají, že majitelé médií deepfake využívat budou. Pouze šestina lidí si myslí, že tomu tak nebude. I v tomto případě s tím nejméně souhlasí ti, kterým je 16 až 24 let.

Falešná videa

Foto: Aktuálně.cz / Shutterstock

Stále zdatnější umělá inteligence pochopitelně umožňuje vyrábět stále pokročilejší a přesvědčivější videa, u nichž lidé obtížněji rozeznávají, zda jde o skutečnost, či nikoliv. Na internetu kolují více méně tři kvalitativní kategorie takových videí: základní (Basic), pokročilá (Advanced) a profesionální (Expert). Na co se tedy ve falešných videích soustředit, abychom je rozpoznali? A jde to vůbec?

Basic

Charakteristika

• nízká kvalita deepfake hlasu

• špatná synchronizace hlasu a videa

• použití ne-deepfake obsahu

Tato videa často používají převážně video editing a deepfake hlas, aby upoutala například na podvodné investice. Nemají dobrou synchronizaci hlasu a videa, kvalita hlasu je často nízká. Záběry jsou často prostříhané s generickým obsahem, deepfake část bývá krátká.

Advanced

Charakteristika

• lepší kvalita videa, zvuku a deepfake hlasu

• lepší synchronizace úst a řeči

• použití televizních zpráv v rámci deepfake podvodu

Pokročilejší deepfake videa s věrohodným deepfake hlasem, dobrou synchronizací úst a řeči a často i dobrým video editingem. Podvodníci často používají formát televizních zpráv, dělají deepfake úpravy moderátorů a známých osobností.

Expert

Charakteristika

• vysoká kvalita deepfake hlasu a synchronizace úst

• kompletní záměna obličeje (např. Volodymyr Zelenskyj, Georgia Meloni)

Zatím nejpokročilejší deepfake videa mohou být skoro nerozeznatelná od reálných videí. Obsahují vysokou kvalitu deepfake hlasu i synchronizace úst, v některých případech dokážou zaměnit i celý obličej oběti. Tento typ deepfaku vyžaduje více zkušeností, prostředků a času na vygenerování. Deepfake na této úrovni byl třeba zaznamenán v období začátku války na Ukrajině (například deepfake se Zelenským nebo Putinem). Lze předpokládat, že do budoucna bude čím dál více deepfake videí spadat do této kategorie.

Manipulace, podvody a cílený útok

Foto: Aktuálně.cz / Shutterstock

Manipulace

Jak už bylo řečeno, deepfaky jsou často využívány i v dezinformačních kampaních, zejména v souvislosti s volbami a formováním veřejného mínění. Objevují se realistická, ale falešná videa politiků, v nichž říkají něco, co nikdy neřekli, nebo se chovají nevhodně. Cílem manipulátorů je ovlivnit názory voličů, zpochybnit důvěryhodnost kandidátů či „zaplevelit” a znepřehlednit mediální prostor, rozšířit chaos a nedůvěru.

Více o manipulacích

Seeing Isn’t Believing – Tackling AI, Misinformation and Its Impact on an Election Year

Klamavá videa šířící dezinformace jsou mocným nástrojem, který může zásadně ovlivnit výsledky voleb. Kvůli manipulativním videím se začne zpochybňovat pravdivost prohlášení a chování politiků. Existuje tak velké riziko, že lidé přestanou věřit všemu. I realitě. Dojde k nevratné erozi důvěry v demokratické instituce, zvýší se riziko polarizace společnosti a posilování extremistických názorů. Ochrana před deepfaky a vzdělávání veřejnosti o jejich existenci je proto klíčové pro udržení integrity demokratických procesů.

Jako příklad mohou posloužit přiložená videa s Volodymyrem Zelenskym, Vladimirem Putinem nebo video s Andrejem Babišem.

Podvody

Deepfake videa se stále častěji využívají v podvodech souvisejících s kryptoměnami a falešnými investicemi. Podvodníci vytvářejí realistická videa se známými osobnostmi, investičními experty nebo influencery, kteří doporučují investice do určitých kryptoměn nebo finančních produktů. Tato videa mohou vypadat velmi přesvědčivě a přesně napodobují hlasy a vzhled skutečných osob. Klam, který zvyšuje šanci, že oběť naletí.

Více o podvodech spojených s kryptoměnami

CryptoCore: Unmasking the Sophisticated Cryptocurrency Scam Operations

Více o podvodech spojených s investicemi

Deepfake scams have robbed companies of millions. Experts warn it could get worse Investiční podvody s lidmi, které nejspíš znáte Gen zablokoval deepfake podvody v hodnotě milionů There's a whole new wave of investment scams - and they feature people you might know

Účelem těchto deepfake podvodů je nalákat lidi k investování do neexistujících projektů nebo podvodných konstruktů, často slibujících vysoké výnosy s minimálním rizikem. Ti, kteří nabídky vyslyší, se následně dostanou do jakéhosi propracovaného kolotoče, na jehož konci mohou zůstat bez veškerých úspo nebor i zadlužení. Stejně jako manželský pár zmíněný v úvodu tohoto materiálu.

Nejúčinnější obranou je být obezřetný a vždy kriticky vyhodnotit jakoukoliv investiční nabídku, zejména pokud je příliš výhodná a je prezentována prostřednictvím videí nebo profilů na sociálních sítích.

Jako příklad mohou posloužit přiložená videa lákající na falešné investice s Elonem Muskem, Andrejem Babišem či Donaldem Trumpem.

Cílené útoky

• Zaměstnanci

Deepfaky se v současnosti využívají rovněž i v takzvaných cílených phishingových útocích, kdy útočníci napodobují nadřízené či vedení společnosti, například generálního ředitele. Pomocí realistických videí nebo audiozáznamů se snaží oklamat zaměstnance, aby vykonali specifické úkoly, jako je převod peněz nebo poskytnutí citlivých informací. Útočníci vytvářejí přesvědčivé deepfake materiály, které mohou vypadat jako autentické projevy a komunikace šéfů, což zvyšuje pravděpodobnost, že zaměstnanci podvod neprokouknou a požadované kroky skutečně provedou.

Další informace

Budoucnost podvodů? Zaměstnanci v Česku zavolal deepfake šéf a ptal se na bankovní účet Finance worker pays out $25 million after video call with deepfake ‘chief financial officer’ Voice fraud scams company out of $243,000

Jak ukazuje případ popsaný v úvodu tohoto materiálu, splnění fiktivních žádostí může mít vážné následky, včetně finančních ztrát pro firmu nebo ohrožení důvěrných dat. Tím, že útočníci zneužívají důvěryhodnost vrcholového vedení, dokážou manipulovat s chováním zaměstnanců a vyvolat vážné bezpečnostní incidenty. Je proto důležité, aby společnosti investovaly do školení zaměstnanců v kybernetické bezpečnosti a rozpoznávání potenciálních podvodných aktivit, aby minimalizovaly riziko takových útoků.

• Příbuzní v nesnázích

Deepfaky se stále častěji používají i v cílených phishingových útocích, při nichž útočníci vytvářejí falešná videa nebo audio nahrávky, kde se představí jako přátelé či příbuzní oběti. Tyto deepfakes simulují skutečný hlas a vzhled, což dodává útokům větší důvěryhodnost.

Další informace

Útočníci obvykle tvrdí, že se nacházejí v nouzi, a žádají o peníze, což může oběti přimět k rychlému a emocionálnímu rozhodnutí. Tento typ podvodu využívá psychologické manipulace a pokročilé technologie k okradení obětí.

Dopady

Foto: Aktuálně.cz / Shutterstock

Podvody

Počet podvodů způsobených deepfake videi nejen ve světě, ale i v Česku každoročně roste. Vloni jich banky či česká policie zaznamenala desetinásobně více než rok předtím. A spolu s tím se hromadí i škody. Například společnost Moneta jen od ledna do září 2024 evidovala 450 napadených klientů. Ztráta dohromady dosahuje skoro 40 milionů korun.

V úvodu zmiňovaný manželský pár, který naletěl na podvodné video napodobující prezidenta Petra Pavla, přišel o milion korun. V některých případech však podvodníci připravili oběti i o násobně větší částky.

V červnu 2024 se například objevila zpráva o ženě z Uherskohradišťska, která falešné investiční společnosti postupně naposílala skoro čtyři miliony korun. Hlavní roli hrálo opět deepfake video, ve kterém známý politik hovořil o unikátní příležitosti zhodnocení peněz. Při podobném případu z května 2024 přišla žena z Kroměřížska o 1,6 milionu korun.

Propracované podvody za použití klamavého videa se zdaleka netýkají jen důvěřivých jednotlivců, podvodníci jsou schopní vylákat stovky milionů korun i z velkých firem, jak dokazuje už zmíněný případ z Hongkongu.

Proč představují deepfakes problém?

Manipulace

Za příklady, kdy falešná videa cíleně manipulují s veřejností, nemusíme cestovat za oceán, byť v zahraničí už dnes dosahují obludných rozměrů. Časopis Misinformation Review ve svém článku ze srpna 2024 označil slovenské parlamentní volby ze září 2023 za první velké politické klání, které výrazně ovlivnil deepfake obsah. Před hlasováním po internetu kolovala například nahrávka předsedy hnutí Progresivní Slovensko Michala Šimečky s novinářkou Monikou Tódovu, ve které se domlouvají na manipulaci s hlasy voličů. Záznam ale vytvořila umělá inteligence.

Oba aktéři se od nahrávky sice ihned distancovali, podle některých mezinárodního expertů na dezinformace však mohla přispět k tomu, že volby vyhrál SMER-SD Šimečkova hlavního konkurenta Roberta Fica. Slovenské volby tak odborníci často nazývají „úsvitem nové éry dezinformací” a očekávají, že podobných scénářů bude v budoucnu přibývat.

Další informace

Beyond the deepfake hype: AI, democracy, and “the Slovak case”

Problém s deepfake videi je však širší. Lidské vnímání videa a zvuku nyní prochází podobnou proměnou, kterou přinesl na přelomu století photoshop u fotografií. Odborníci upozorňují na to, že problémem je nejen snadné vytváření falešných videí, ale také skutečnost, že každý záznam lze nyní označit za deepfake podvrh a znevěrohodnit i reálné záběry. A na co se pak lidé mohou spolehnout, když toho nejsou přímými svědky.

Americká média například upozornila na to, že tento přístup už loni zkoušeli u soudu právníci miliardáře Elona Muska. Jeho společnost Tesla žalovala rodina muže, který zemřel po autonehodě ve chvíli, kdy měl svůj vůz nastavený na režim autopilota. Podle pozůstalých tak učinil na základě tvrzení Muska, že jde o nejbezpečnější způsob přepravy v Tesle. Právníci miliardáře ale přišli s tvrzením, že mohlo jít o deepfake video. Soudce však tento argument odmítl.

Jak rozpoznat deepfake

Uživatelé internetu stojí před klíčovou otázkou: jak deepfake video rozpoznat od reálných záběrů? To může být pro mnohé z nás velmi složité. Vždyť ještě před pár lety nebylo vůbec možné vytvořit video tak dokonale napodobující politiky, slavné osobnosti, kohokoliv.

Falešné video může prozradit i přehnaná barevnost

Video: Tomáš Klézl, Blahoslav Baťa

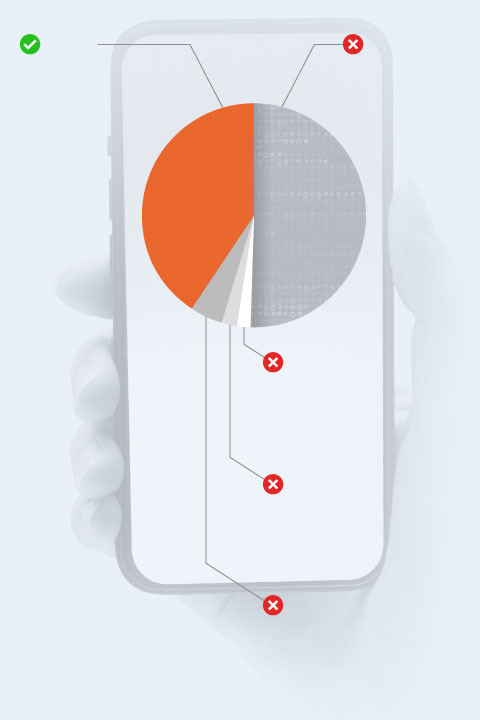

Navíc je ve stále větší míře konzumujeme prostřednictvím malých obrazovek telefonů, což je pro jakýkoliv upravený materiál výhodou. Videozáznamy se pak po internetu šíří velmi rychle, a než se povede věc uvést na pravou míru, dostanou se zpravidla k velkému počtu uživatelů.

Ač kvůli moderním technologiím mohou videa působit mimořádně věrohodně, stále je lze ve většině případů odlišit od skutečnosti. Ale vyžaduje to pozornost.

Aktuálně.cz dalo spolu s firmou Gen dohromady několik základních rad, kterými se mohou lidé řídit, pokud narazí na podezřelé video.

Jak je možné rozpoznat deepfake video

Je ale třeba dodat, že tvůrci těchto podvodných videí o popsaných nedokonalostech vědí a snaží se obsah zdokonalovat. Lze také předpokládat, že deepfake technologie budou postupovat dopředu. Část těchto doporučení tak časem nemusí platit.

Pokrok však lze očekávat i na druhé straně barikády. Technologické firmy pracují na programech, které by uměly podstatnou část deepfake videí rozpoznat a uživatele na ně upozornit.

Původní vs. fakevideo

Originál

Fake

Původní video zachycuje někdejšího premiéra Andreje Babiše, jak v době covidové pandemie oznamuje umožnění přicestování do země pro zahraniční cestovatele.

Falešné video ukazuje také skutečný záznam Babiše, ale doplněný o zvuk vytvořený deepfake technologií. Premiérův hlas nabádá lidi k údajně výhodné investici. Podvodníci doplnili také grafické prvky, které mají vytvořit dojem, že jde o televizní přenos.

Fotografie ve speciálu: Aktuálně.cz, Shutterstock | Deepfake videa poskytla společnost Gen Digital.

My a dezinformace

Klamavé zprávy, účelové lži, manipulace. Dezinformace. Zhruba třetina Čechů alespoň některým věří, asi desetina zcela podléhá. Člověka děsí falešným nebezpečím, klamou, oslabují jeho schopnost racionálního uvažování, důvěru ve společenství, rodinu, stát. Rozsáhlý projekt Aktuálně.cz přináší přehledný, komplexní a stále aktualizovaný materiál, který mohou využívat školy, rodiče, studenti, kdokoli.